在学习Kubernetes网络模型时,了解各种网络组件的作用以及它们如何交互是非常重要的。本文将介绍Kubernetes集群中各种网络组件如何交互,以及如何帮助每个Pod获取IP地址。

Kubernetes网络模型的一个核心要求是每个Pod都拥有自己的IP地址,并能够使用该IP地址进行通信。许多人在刚开始使用Kubernetes时,不清楚如何为每个Pod分配IP地址。他们知道各种组件如何独立工作,但不清楚这些组件如何协同工作。例如,他们知道什么是CNI插件,但不知道它们是如何被调用的。本文将介绍Kubernetes集群中各种网络组件如何交互,以及如何帮助每个Pod获取IP地址。

在Kubernetes中,有多种网络设置方法和container runtime选项。本文将使用Flannel作为network provider,并使用Containerd作为container runtime。

背景概念

容器网络

同一主机上的容器

在同一主机上运行的容器可以通过使用Linux Bridge来实现通过IP地址相互通信。也就是说,在Kubernetes(和Docker)世界中,可以创建veth(虚拟以太网)设备。该veth设备的一端连接到容器网络命名空间,另一端连接到主机网络上的Linux Bridge。同一主机上的所有容器都将这veth pair的一端连接到Linux Bridge,它们可以通过Bridge使用IP地址相互通信。Linux Bridge也被分配了一个IP地址,它充当从目的地到不同节点的Pod流出流量的网关。

不同主机上的容器

在不同主机上运行的容器可以通过其 IP 地址相互通信的方式之一是使用数据包封装(packet encapsulation)。Flannel 通过 vxlan 使用该功能,vxlan 将原始数据包封装在 UDP 数据包中并将其发送到目的地。

在 Kubernetes 集群中,Flannel 会在每个节点上创建一个 vxlan 设备和一些路由表。每个发往不同主机上的容器的数据包都会通过 vxlan 设备,并封装在 UDP 数据包中。在目标位置,它会提取封装的数据包,然后将数据包路由到目的地 Pod。

“

注意:这只是配置容器之间网络的方法之一。

”

CRI

CRI(容器运行时接口)是一个插件接口,允许 kubelet 使用不同的 container runtimes。各种 container runtimes 都实现了 CRI API,这使用户可以在 Kubernetes 安装中使用他们想要的 container runtimes。

CNI

CNI(容器网络接口)项目包含一个为 Linux 容器提供基于通用插件网络解决方案的规则。它由各种插件组成,这些插件在配置 Pod 网络时执行不同的功能。CNI 插件是遵循 CNI 规范的可执行文件。

为节点子网分配 Pod IP 地址

如果要求所有 Pod 具有 IP 地址,那么就要确保整个集群中的所有 Pod 的 IP 地址是唯一的。这可以通过为每个节点分配一个唯一的子网来实现,即从子网中为 Pod 分配节点 IP 地址。

节点 IPAM 控制器

当 nodeipam 传递给 kube-controller-manager 的 --controllers 命令行标志时,它将为每个节点分配来自集群 CIDR(集群网络的 IP 范围)的专用子网(podCIDR)。由于这些 podCIDR 是不相交的子网,因此它可以为每个 Pod 分配唯一的 IP 地址。

当 Kubernetes 节点首次在集群上注册时,会被分配一个 podCIDR。要更改分配给集群中节点的 podCIDR,需要先注销节点,然后使用应用于 Kubernetes 控制平面的任何配置更改来重新注册节点。podCIDR 可以使用以下命令列出节点的名称:

Kubelet、Container Runtime 和 CNI 插件交互

当在节点上调度 Pod 时,一启动 Pod 就会发生很多事情。这里我们仅关注与 Pod 配置网络有关的动态。一旦在节点上调度了 Pod,将配置网络并启动应用程序容器。

参考:容器式 cri 插件架构

Container Runtime 与 CNI 插件的交互

每个 network provider 都有一个 CNI 插件,container runtime 会调用该插件,在 Pod 启动时配置网络。使用容器化作为 container runtime,容器化 CRI 插件将调用 CNI 插件。每个 network provider 都在每个 Kubernetes 节点上安装了一个代理,以配置 Pod 网络。安装 network provider agent 后,它会随 CNI 一起配置或者在节点上创建,CRI 插件会使用它来确定要调用哪个 CNI 插件。

CNI 配置文件的位置是可配置的,默认值为 /etc/cni/net.d/。集群管理员需要在每个节点上交付 CNI 插件。CNI 插件的位置也是可配置的,默认值为 /opt/cni/bin。

如果使用 containerd 作为 container runtime,则可以在 containerd config 部分下 [plugins."io.containerd.grpc.v1.cri".cni] 指定 CNI 配置和 CNI 插件的路径。

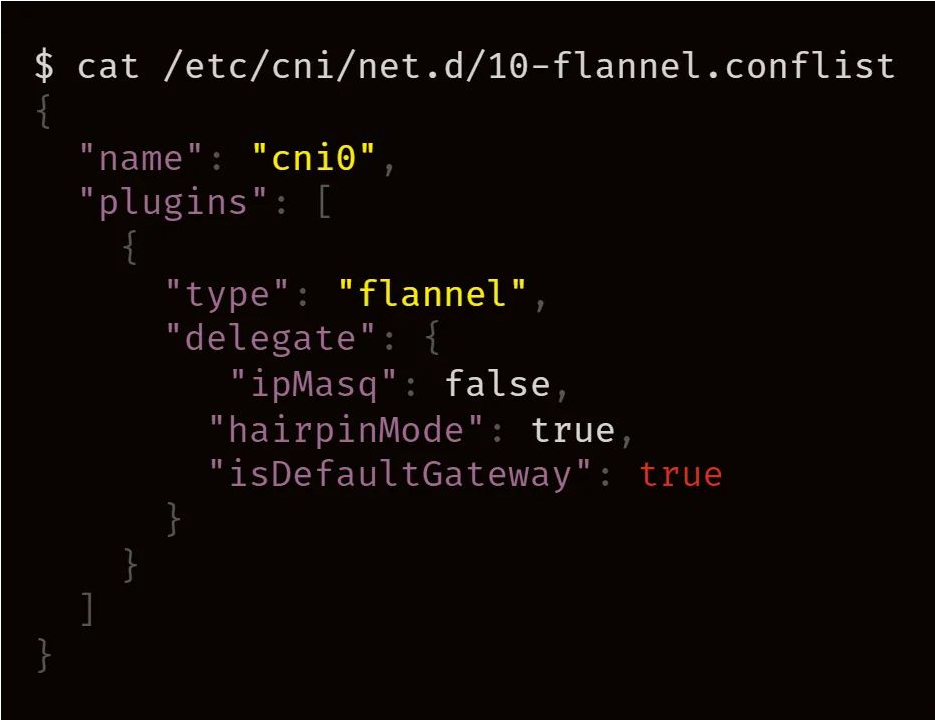

本文中我们将 Flannel 作为 network provider,这里简单介绍一下 Flannel 的设置。Flanneld 是 Flannel 守护程序,通常 install-cni 作为带有初始化容器的守护程序安装在 Kubernetes 集群上。install-cni 容器创建 CNI 配置文件在每个节点上 /etc/cni/net.d/10-flannel.conflist。Flanneld 创建一个 vxlan 设备,从 apiserver 获取网络元数据,并监控 Pod 上的更新。创建 Pod 时,它将在整个集群中为所有 Pod 分配路由,这些路由允许 Pod 通过 IP 地址相互连接。

Containerd CRI 插件和 CNI 插件之间的交互可以如下所示:

如上所述,kubelet 调用 Containered CRI 插件创建容器,再调用 CNI 插件为容器配置网络。Network provider CNI 插件调用其他基本 CNI 插件来配置网络。CNI 插件之间的交互如下所述。

CNI 插件之间的交互

有多种 CNI 插件可帮助配置主机上容器之间的网络,本文主要讨论以下 3 个插件。

Flannel CNI 插件

当使用 Flannel 作为 network provider 时,Containered CRI 插件使用 CNI 配置文件,调用 Flannel CNI 插件:/etc/cni/net.d/10-flannel.conflist。

Fannel CNI 插件与 Flanneld 结合使用,当 Flanneld 启动时,它将从 apiserver 中获取 podCIDR 和其他与网络相关的详细信息,并将它们存储在文件中/run/flannel/subnet.env。

Flannel CNI 插件使用 /run/flannel/subnet.env 的信息来配置和调用 Bridge CNI 插件。

Bridge CNI 插件

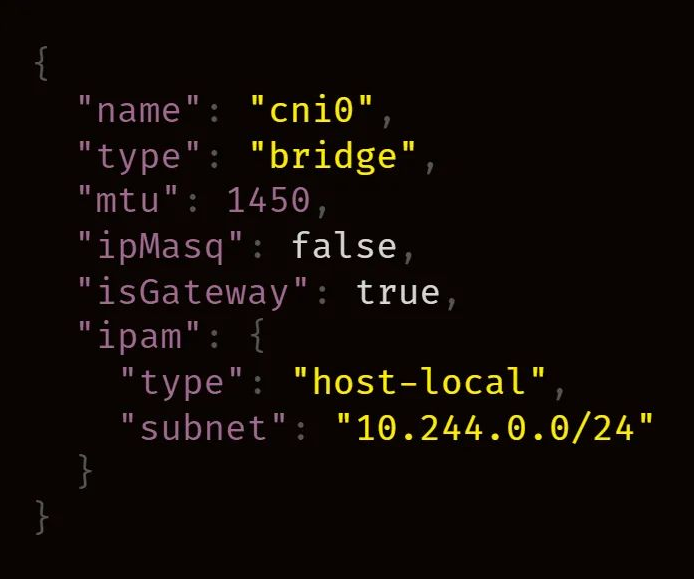

Flannel CNI 插件使用以下配置调用 Bridge CNI 插件:

当 Bridge CNI 插件第一次调用时,它会创建一个 Linux Bridge "name": "cni0" 在配置文件中,然后为每个 Pod 创建 veth pair,其一端在容器的网络命名空间中,另一端连接到主机网络上的 Linux Bridge。使用 Bridge CNI 插件,主机上的所有容器都连接到主机网络上的 Linux Bridge。

配置完 veth pair 后,Bridge 插件将调用主机本地 IPAM CNI 插件。我们可以在 CNI config 中配置要使用的 IPAM 插件,CRI 插件用于调用 Flannel CNI插件。

主机本地 IPAM CNI 插件

Bridge CNI 插件使用以下配置调用主机本地 IPAM CNI 插件:

主机本地 IPAM(IP 地址管理)插件从中返回容器的 IP 地址,subnet将分配的 IP 本地存储在主机下dataDir指定的目录中/var/lib/cni/networks/。/var/lib/cni/networks/文件包含 IP 分配到的容器 ID。

调用时,主机本地 IPAM 插件返回以下有效负载:

总结

Kube-controller-manager 为每个节点分配一个 podCIDR。从 podCIDR 中的子网值为节点上的 Pod 分配了 IP 地址。由于所有节点上的 podCIDR 是不相交的子网,因此它允许为每个 pod 分配唯一的IP地址。

Kubernetes 集群管理员可配置和安装 kubelet、container runtime、network provider,并在每个节点上分发 CNI 插件。Network provider agent 启动时,将生成 CNI 配置。在节点上调度 Pod 后,kubelet 会调用 CRI 插件来创建 Pod。在容器情况下,容器的 CRI 插件调用 CNI 配置中指定的 CNI 插件来配置 Pod 网络。所有这些都会影响 Pod 获取 IP地址。

以上就是良许教程网为各位朋友分享的Linu系统相关内容。想要了解更多Linux相关知识记得关注公众号“良许Linux”,或扫描下方二维码进行关注,更多干货等着你 !

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏

.png)